Google представила ряд новых решений в сфере агентского ИИ. Среди них: режим глубоких исследований в NotebookLM, «мозг для роботов» SIMA 2 и инструменты для шопинга.

Корпорация Google представила ряд новых решений в сфере агентского ИИ. Среди них: режим глубоких исследований в NotebookLM, «мозг для роботов» SIMA 2 и инструменты для шопинга.

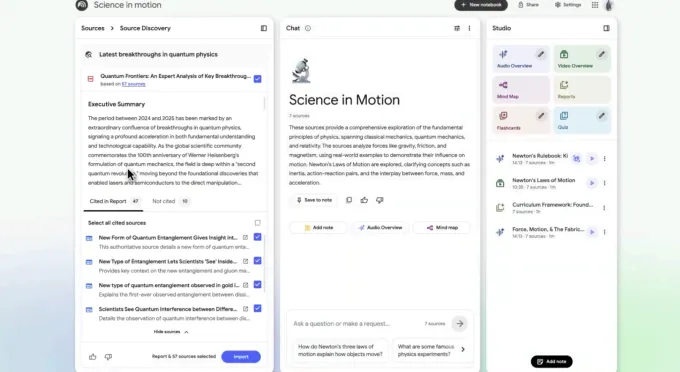

Google обновила ИИ-ассистента для заметок NotebookLM. Добавлен инструмент для упрощения сложных исследований и поддержка дополнительных типов файлов.

Сервис запустил Deep Research — решение для автоматизации онлайн-поиска. Компания утверждает, что он работает как отдельный исследователь: способен подготовить развернутый отчет или порекомендовать релевантные статьи, научные работы и сайты.

Deep Research получает вопрос, составляет исследовательский план и просматривает веб-ресурсы. Через несколько минут он предоставляет основанный на источниках отчет, который можно сразу добавить в блокнот.

Режим работает в фоне — параллельно есть возможность выполнять другие задачи.

Источник: Google.

Источник: Google.

Инструмент доступен через поиск. Можно выбрать стиль исследования: детальный Deep Research или быстрый Fast Research.

Дополнительно в NotebookLM добавлена поддержка Google Sheets, файлов из Drive в виде URL, PDF из Google Drive и документов Microsoft Word.

Обновления появятся в течение недели.

NotebookLM — ИИ-ассистент для заметок, исследований и работы с документами от Google. Он позволяет загружать материалы — PDF, статьи, таблицы, картинки, ссылки, юридические документы, лекции — и формировать структурированную базу знаний.

Сервис запустили в 2023 году. С тех пор его возможности постепенно расширяются за счет искусственного интеллекта. В начале 2025 года появилась функция Video Overviews, которая превращает сложный мультимедийный материал в понятные визуальные презентации.

В мае NotebookLM стал доступен на Android и iOS.

Google продолжает развивать направление «мозга» для робототехники.

Подразделение DeepMind представило SIMA 2 — новое поколение универсального ИИ-агента. Он «выходит за рамки простого выполнения инструкций», начинает понимать окружающую среду и взаимодействовать с ней.

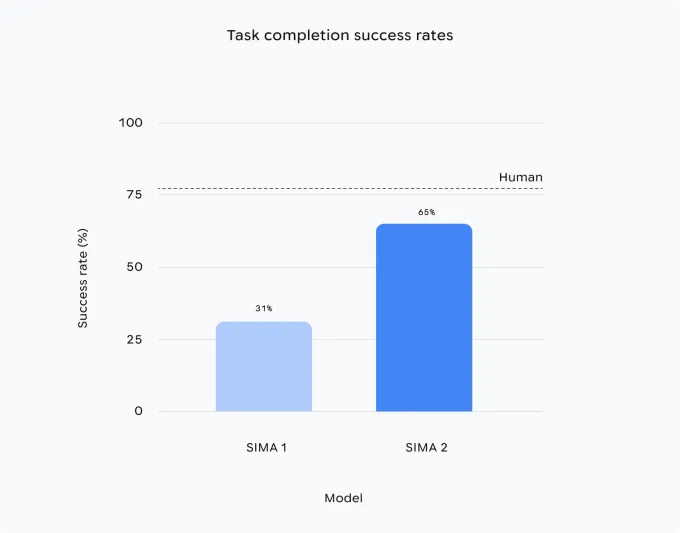

Первая версия SIMA обучалась на сотнях часов геймплейных видеозаписей, чтобы научиться играть в различные 3D-игры как человек. Ее представили в марте 2024 года. Модель могла выполнять базовые команды в разных виртуальных мирах, но со сложными задачами лишь в 31% случаев.

SIMA 2 опирается на языковые и аналитические возможности Gemini и работает на базе версии 2.5 flash-lite. Точность выросла до 65%.

«SIMA 2 — качественный скачок по сравнению с SIMA 1. Это более универсальный агент. Он умеет выполнять сложные задачи в новой среде, в которой раньше не был», — сказал на пресс-брифинге старший научный сотрудник DeepMind Джо Марино.

Ассистент способен самообучаться — улучшать свои навыки на основе личного опыта. Это шаг в сторону более универсальных роботов и систем, отметил Марино.

Производительность SIMA 2 в два раза выше по сравнению с первой версией. Источник: Google DeepMind.

Производительность SIMA 2 в два раза выше по сравнению с первой версией. Источник: Google DeepMind.

Исследователи ИИ-подразделения Google подчеркнули, что работа над так называемыми «воплощенными агентами» критически важна для развития общего интеллекта. Подобный помощник должен уметь взаимодействовать с физическим и виртуальными миром через тело — как человек или робот.

Невоплощенный ассистент может управлять календарем, делать заметки или выполнять код, объяснил Марино.

Источник: Google.

Источник: Google.

Старший научный сотрудник DeepMind с нейробиологическим бэкграундом Джейн Ван подчеркнула, что SIMA 2 выходит далеко за рамки обычного игрового поведения.

«Мы требуем от него действительно понимать, что происходит, что от него хотят, и реагировать здраво и по смыслу. Это на самом деле довольно сложно», — сказала она.

Интеграция Gemini позволила SIMA 2 удвоить показатели предыдущей версии. Модель сочетает развитые языковые и аналитические возможности ИИ с навыками «воплощенного» взаимодействия, полученными в процессе обучения.

Марино продемонстрировал SIMA 2 в игре No Man’s Sky. Агент описывал окружение — каменистую поверхность планеты — и определял свои следующие действия. Для внутренних рассуждений он использовал Gemini.

В другой игре помощника попросили подойти к дому цвета спелого томата. ИИ показал процесс анализа: «он красный, значит идти нужно к дому соответствующего цвета». Затем ассистент начал двигаться в нужном направлении.

Благодаря применению Gemini ИИ-агент понимает инструкции даже в виде эмодзи. Команда «?» заставит его рубить дерево.

SIMA 2 ориентируется в сгенерированных с помощью Genie фотореалистичных мирах. Он корректно распознает объекты вроде скамеек, деревьев, бабочек и способен взаимодействовать с ними.

Благодаря Gemini новая версия SIMA способна самообучаться почти без участия человека, используя предоставленные данные лишь как базовый ориентир.

Команда помещает агента в новую среду, а отдельная модель генерирует для него задания.

Generalization SIMA 2 is now far better at carrying out detailed instructions, even in worlds it's never seen before.It can transfer learned concepts like “mining” in one game and apply it to “harvesting” in another – connecting the dots between similar tasks.It even… pic.twitter.com/ANldQVWFd4

— Google DeepMind (@GoogleDeepMind) November 13, 2025SIMA 2 анализирует свои недочеты и постепенно улучшает навыки. По сути, это обучение методом проб и ошибок, но без участия человека: роль наставника выполняет другая система искусственного интеллекта.

В DeepMind считают, что новое решение — шаг к созданию по-настоящему универсальных роботов.

«Системе для выполнения задач в реальном мире нужно два ключевых элемента: высокоуровневое понимание мира и способность к рассуждению», — отметил старший инженер-исследователь подразделения Фредерик Бесс.

Если человек попросит гуманоидного робота проверить, сколько банок фасоли осталось в шкафу, ему нужно понимать, что такое фасоль, шкаф, и уметь добраться до нужного места.

SIMA 2 как раз затрагивает этот «высокий уровень поведения», отметил Бесс.

Сроки интеграции нового решения в физических роботов пока неизвестны.

Еще одна интересующая поискового гиганта сфера — ИИ-покупки. Компания выпустила набор новых инструментов для онлайн-шопинга. Среди них:

«Мы считаем, что процесс покупок не должен быть таким утомительным. Идея в том, чтобы сохранить все приятные части процесса — просмотр товаров, случайные находки — и убрать скучные и трудные этапы», — отметила вице-президент и руководитель направления рекламы и коммерции в Google Видхья Срнивасан.

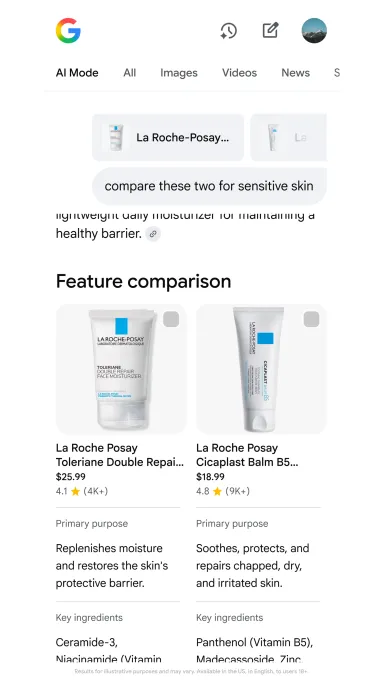

Один из апдейтов — разговорные покупки в режиме AI Mode. Пользователь может общаться с поисковиком как с чат-ботом, а тот покажет картинки товаров, добавит детали вроде цены, отзывов и наличия.

Источник: Google.

Источник: Google.

Приложение Gemini научили формировать развернутые идеи и подборки, а не ограничиваться короткими текстовыми советами по шопинг-запросам. Пока функция доступна только в США.

Агентский чек-аут — автоматическая проверка изменений касательно интересующего товара. Сервис способен присылать уведомления о снижении цены.

«Это полезно для покупателей — им не нужно постоянно проверять цену на нужный товар. И это полезно для продавцов — покупатели вернутся, хотя противном случае ушли бы», — сказала вице-президент по продуктам Google Shopping Лилиан Ринкон.

Еще одна новая функция позволяет ИИ звонить в магазины от имени пользователя и спрашивать о наличии товара, а также действующих акциях. Она основана на базе представленной в 2018 году технологии Google Duplex, Shopping Graph и платежной инфраструктуре Google.

Для применения инструмента нужно указать желаемый товар. ИИ обзвонит локальные магазины, спросит детали и предоставит краткий отчет.

Напомним, в ноябре Google добавила сводки сообщений, приоритизацию уведомлений и другие функции на базе искусственного интеллекта в смартфоны Pixel.

Google занялась разработкой ИИ-агентов для управления термоядерным синтезом