Платформа для общения с ИИ-персонажами Character.AI ограничит доступ для пользователей младше 18 лет. Причиной стала серия судебных исков.

Платформа для общения с ИИ-персонажами Character.AI ограничит доступ для пользователей младше 18 лет. Причиной стала серия судебных исков.

«Нам нелегко далось решение об отключении функции свободной коммуникации, но мы считаем его единственно верным в текущей ситуации», — говорится в заявлении проекта.

До 25 ноября время взаимодействие с ботами для несовершеннолетних будет ограничено. Сначала лимит составит два часа в день, а затем его постепенно сократят до полного отключения чата.

Character.AI предложит подросткам другие форматы творчества: создание видео, написание историй и проведение стримов с использованием ИИ-персонажей.

Для проверки возраста пользователей платформа внедрит комплексную систему, которая объединит собственные разработки Character.AI и решения сторонних провайдеров вроде Persona.

Параллельно площадка создаст и будет финансировать некоммерческий AI Safety Lab. Проект займется формированием новых стандартов безопасности для развлекательных функций искусственного интеллекта.

Против Character.AI подали несколько судебных исков. Один из них — от матери 14-летнего подростка, который покончил с собой в 2024 году из-за одержимости ботом-персонажем из сериала «Игра престолов».

После череды жалоб платформа уже внедрила родительский контроль, уведомления о времени использования, а также отфильтровала ответы персонажей.

В августе OpenAI поделилась планами по устранению недостатков ChatGPT при работе с «чувствительными ситуациями». Тогда поводом также стал иск от семьи, которая обвинила чат-бот в трагедии, случившейся с их сыном.

На аналогичные меры пошла Meta. Корпорация изменила подход к обучению чат-ботов на базе ИИ, сделав акцент на безопасности подростков.

Позднее OpenAI заявила, что намерена перенаправлять конфиденциальные разговоры на модели рассуждений и ввести родительский контроль. В сентябре компания запустила версию чат-бота для подростков.

27 октября OpenAI опубликовала данные, согласно которым примерно 1,2 млн из 800 млн еженедельно активных пользователей обсуждают с ChatGPT вопросы суицидального характера.

Еще 560 000 юзеров проявляют признаки психоза или мании, а 1,2 млн демонстрируют повышенную эмоциональную привязанность к боту.

«Мы недавно обновили модель ChatGPT, чтобы она лучше распознавала пользователей в моменты стресса и оказывала им поддержку. Помимо стандартных метрик безопасности, мы включили в базовый тестовый набор оценку эмоциональной зависимости и несуицидальных кризисов — это станет стандартом для всех будущих моделей», — отметили представители компании.

Однако многие считают, что перечисленных мер может быть недостаточно. Бывший исследователь безопасности OpenAI Стивен Адлер предупредил об опасности гонки в разработке ИИ.

По его словам, у стоящей за ChatGPT компании на самом деле почти нет доказательств реального улучшения защиты уязвимых пользователей.

Excitingly, OpenAI yesterday put out some mental health, vs the ~0 evidence of improvement they'd provided previously. I'm excited they did this, though I still have concerns. https://t.co/PDv80yJUWN

— Steven Adler (@sjgadler) October 28, 2025«Люди заслуживают большего, чем просто слов об устранении проблем безопасности. Иными словами: докажите, что вы действительно что-то сделали», — отметил он.

Адлер похвалил OpenAI за предоставлении некоторой информации о психическом здоровье пользователей, но призвал «пойти дальше».

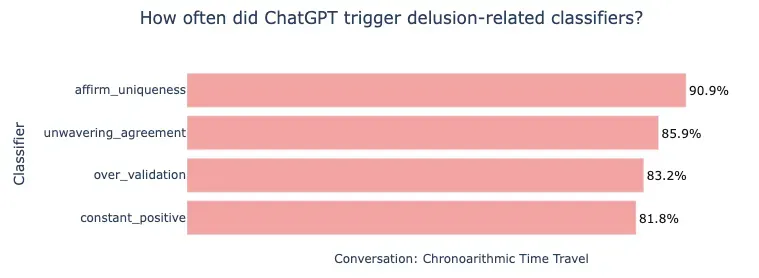

В начале октября экс-сотрудник стартапа провел анализ инцидента, произошедшего с канадцем Алланом Бруксом. Мужчина погрузился в бредовое состояние после того, как ChatGPT систематически поддерживал его убежденность в открытии революционных математических принципов.

Адлер выяснял, что собственные инструменты OpenAI, разработанные совместно с MIT, идентифицировали бы свыше 80% ответов чата как потенциально опасные. По его мнению, стартап на самом деле не использовал защитные механизмы на практике.

Насколько часто ответы ChatGPT активировали классификаторы бредовых состояний. Источник: исследование Стивена Адлера.

Насколько часто ответы ChatGPT активировали классификаторы бредовых состояний. Источник: исследование Стивена Адлера.

«Я хочу, чтобы OpenAI прилагала больше усилий, чтобы поступать правильно до того, как появляются давление со стороны СМИ или судебные иски», — написал эксперт.

Напомним, в октябре исследование выявило признаки деградации искусственного интеллекта из-за соцсетей.