Исследователи из Apple выяснили, что даже самые продвинутые языковые модели с функцией «размышления» не способны к обобщенному решению задач.

Исследователи из Apple выяснили, что даже самые продвинутые языковые модели с функцией «размышления» (LRM) не способны к обобщенному решению задач. Их способность к логике оказалась ограниченной, а в некоторых случаях — иллюзорной.

Команда провела эксперимент, чтобы понять реальные возможности и ограничения моделей вроде OpenAI o1/o3, Claude 3.7 Sonnet Thinking и DeepSeek-R1. Эти системы генерируют подробные цепочки рассуждений перед тем, как дать ответ, что должно улучшать их производительность.

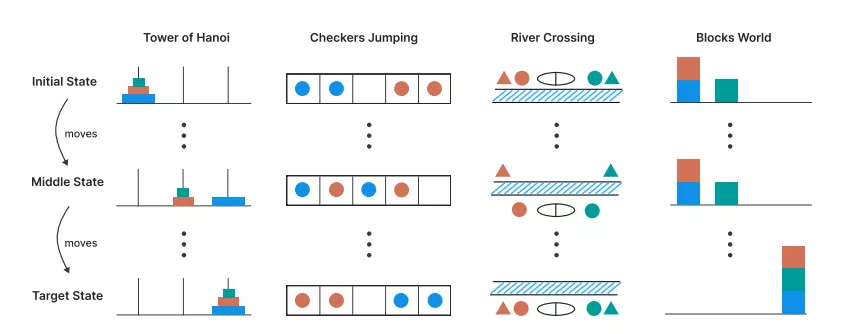

Вместо стандартных математических тестов, которые могут быть «загрязнены» данными из интернета, команда использовала контролируемые головоломки. Среди них были Ханойская башня, Переправа через реку и Мир блоков. Такой подход позволил точно измерять сложность задачи, меняя количество элементов, и анализировать не только конечный ответ, но и весь процесс «мышления» модели.

Иллюстрация головоломок: Ханойская башня, Прыжок в шашках, Переправа через реку и Мир блоков. Данные: Apple.

Иллюстрация головоломок: Ханойская башня, Прыжок в шашках, Переправа через реку и Мир блоков. Данные: Apple.

Главный вывод исследования — производительность всех современных LRM-моделей падает до нуля, как только сложность головоломки превышает определенный порог.

Усилия на «размышления», измеряемые в количестве использованных токенов, растут вместе со сложностью задачи, но только до определенного момента. Перед полным провалом модель парадоксально начинает «думать» меньше, хотя у нее достаточно вычислительных ресурсов для генерации длинного ответа. Это указывает на фундаментальный предел масштабирования их логических способностей.

Сравнив «думающие» модели с их стандартными версиями (LLM), исследователи выделили три режима работы в зависимости от сложности задачи:

Исследователи предоставили модели точный алгоритм для решения Ханойской башни, который требовал лишь последовательного выполнения шагов. Однако она все равно потерпела крах на том же уровне сложности, что и при самостоятельном поиске решения. Это ставит под сомнение их способность к выполнению точных вычислений и логике.

Авторы пришли к выводу, что нынешние LRM, несмотря на сложные механизмы саморефлексии, не обладают обобщаемыми навыками решения проблем. Их успехи могут быть связаны, скорее, с продвинутым сопоставлением с образцом, а не с реальным процессом рассуждения, что делает термин «иллюзия мышления» из заголовка исследования весьма точным.

Напомним, в мае биржа OKX выпустила отчет, в котором говорится, что искусственный интеллект и блокчейн открывают новые подходы к получению дохода в различных отраслях.

Галлюцинации остались основной проблемой ИИ